فهرست مطالب

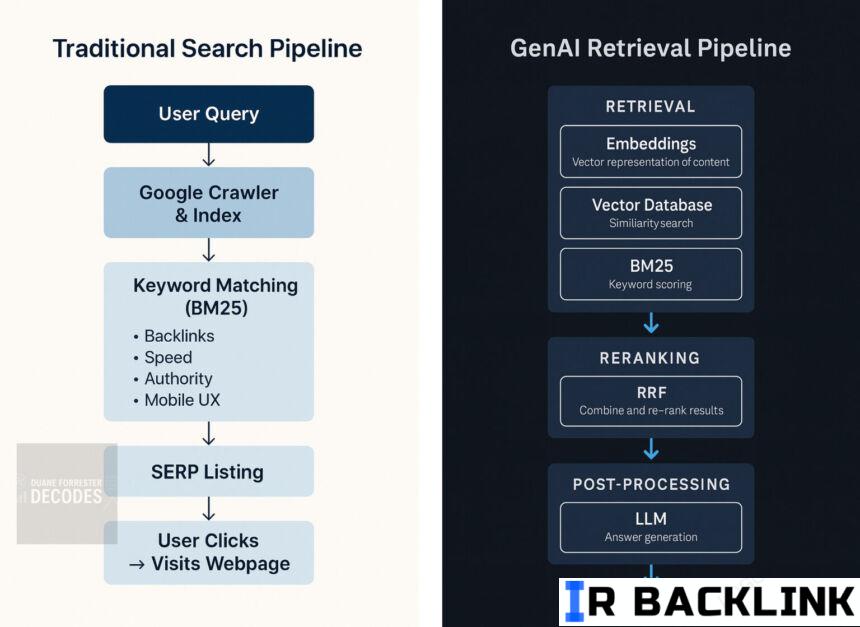

صفحه دیگه مهم نیست. حالا نوبت استکه. یعنی چی؟ یعنی همه چیز عوض شده. حالا پای پایگاههای داده برداری (Vector Databases)، مدلهای تعبیهسازی (Embeddings) و الگوریتم ترکیب رتبه معکوس (Reciprocal Rank Fusion) وسط اومده و ساختار جستجو رو از پایه تغییر داده.

تا همین چند وقت پیش، سئو به سبک کلاسیک اینطوری بود: یکی میاومد تو گوگل سرچ میکرد “بهترین عینک آفتابی هوشمند”، و بعد لینکهای صفحه نتایج یا همون SERP رو بررسی میکرد.

اما حالا چی؟ یکی میپرسه: «داستان این Ray-Banهای متای جدید چیه؟» و به جای دیدن یه عالمه لینک، یه جواب ترکیبی از ویژگیها، کاربردها و حتی نظرات کاربران دریافت میکنه – بدون اینکه لزوماً هیچ صفحهای یا حتی SERP نشون داده بشه!

این دقیقاً همون جاییه که مفهوم جدیدی به اسم سئو برای جستجوی هوش مصنوعی خودش رو نشون میده. تو این مدل جدید، دیگه مهم نیست محتوای تو کجای نتایج رتبهبندی شده. مهم اینه که قابل بازیابی (retrievable) باشه، درک بشه و بتونه وارد پاسخ نهایی بشه.

قبلاً داستان اینطوری بود: یه صفحه مینوشتی، صبر میکردی تا گوگل یا بینگ بخزن داخلش، امیدوار بودی کلمات کلیدیات با کوئری کاربر بخونه، و آخرشم دعا میکردی کسی جایگاه اول رو با تبلیغات پولی نخریده باشه.

اما این مدل داره کمکم محو میشه. چون حالا مدلهای زبان بزرگ (Large Language Models یا LLMs) دیگه نیازی به لیست صفحات ندارن. فقط کافیه محتوای تو به شکل درست ساختار داده شده باشه، قابل تفسیر باشه و در زمان لازم، آماده استفاده باشه.

اینجا دیگه خبری از لینک و رتبه نیست. این ساختار جدید جستجوعه – ساخته شده بر پایه بردارها، تعبیهسازی معنایی، ترکیب رتبه و مدلهایی که استدلال میکنن نه رتبهبندی.

پس دیگه فقط صفحه رو بهینه نمیکنی. باید کاری کنی که محتوای تو به درستی شکسته بشه، به شکل معنایی امتیاز بخوره و بعد هم ترکیب بشه تا جواب بسازه.

وقتی بفهمی این جریان جدید چطور کار میکنه، اون روشهای قدیمی سئو یه جورایی خندهدار به نظر میان. (البته اینجا داریم فرآیند رو خیلی سادهشده توضیح میدیم.)

آشنایی با ساختار جدید جستجو

زیر پوست هر سیستم هوش مصنوعی مدرن که با بازیابی اطلاعات کار میکنه (retrieval-augmented AI)، یه استک پیچیده ولی نامرئی وجود داره. چیزی که کاربرها هیچوقت نمیبیننش، ولی کاملاً متفاوت از مدلهایی هست که تا الان میشناختیم.

تعبیهسازیها (Embeddings)

هر جمله، پاراگراف یا سند، به یک بردار (Vector) تبدیل میشه – یه نمای چندبُعدی از معنای اون متن.

این کار باعث میشه ماشینها بهجای اینکه صرفاً به دنبال کلمات کلیدی بگردن، بتونن محتواها رو بر اساس شباهت مفهومی با هم مقایسه کنن. مثلاً ممکنه یه متن اصلاً از کلمه کلیدی تو استفاده نکرده باشه، ولی باز هم برای کوئری کاربر مرتبط تشخیص داده بشه.

پایگاههای داده برداری (Vector Databases یا Vector DBs)

اینجا همونجاییه که اون بردارها ذخیره و در زمان لازم، سریع بازیابی میشن. نمونههای معروف این نوع پایگاهدادهها عبارتند از: Pinecone، Weaviate، Qdrant و FAISS.

وقتی کاربر سوالی میپرسه، خود سوال هم تبدیل به بردار میشه. و این پایگاهدادهها تو کسری از ثانیه، نزدیکترین قطعات محتوا رو برمیگردونن.

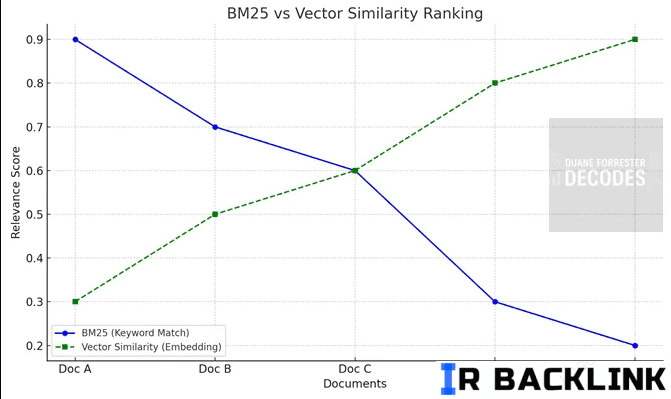

BM25

یه الگوریتم کلاسیک؟ بله.

ولی هنوزم کاربردی؟ صد درصد!

الگوریتم BM25 هنوز هم برای جستجوی دقیق با استفاده از تکرار و نادر بودن کلمات کلیدی عالی عمل میکنه.

اگه کاربر دنبال یه عبارت خاص یا اصطلاح خاص باشه، BM25 خیلی خوب جواب میده. چون دقیقاً دنبال تطابق مستقیم میگرده.

توی نمودار مقایسهای که در مقاله هست، نشون داده شده که الگوریتم BM25 چطور در مقابل سیستم رتبهبندی با شباهت برداری (Vector Similarity Ranking) عمل میکنه. اولی تمرکز زیادی روی کلمات کلیدی داره، دومی اما شباهت مفهومی محتواها رو بررسی میکنه – و هر کدوم در موقعیتی خاص بهتر جواب میدن.

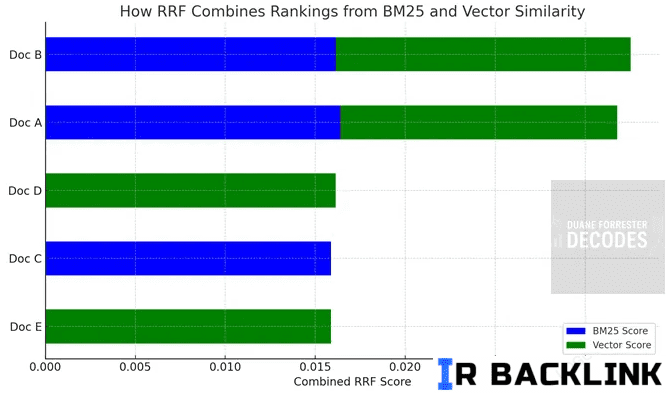

ترکیب رتبه معکوس (Reciprocal Rank Fusion یا RRF)

اینجا به یه مدل ترکیبی میرسیم. RRF میاد و خروجی چند روش مختلف مثل BM25 و رتبهبندی برداری رو با هم ترکیب میکنه و یه لیست نهایی از نتایج میسازه.

این روش کمک میکنه تا نه کلمات کلیدی به تنهایی، و نه صرفاً شباهت مفهومی، باعث تسلط کامل بر نتیجه نهایی بشن. در عوض، یه تعادل هوشمند ایجاد میشه.

RRF با استفاده از امتیازهای معکوس رتبه (reciprocal rank scores) مشخص میکنه که هر سند در مدلهای مختلف چه جایگاهی داره، و اونی رو بیشتر ترجیح میده که تو چند روش مختلف جایگاه خوبی داشته – حتی اگه در هیچکدوم رتبه اول نبوده باشه.

این یعنی تو ساختار جدید سئو برای جستجوی هوش مصنوعی، باید محتوایی تولید کنی که هم از نظر کلمات کلیدی قوی باشه، هم از نظر مفهومی – تا توی این مدلهای ترکیبی مثل RRF شانس بالاتری برای دیده شدن داشته باشه.

مدلهای زبانی بزرگ (Large Language Models یا LLMs)

وقتی نتایج برتر با استفاده از الگوریتمهای مختلف بازیابی شدن، حالا نوبت مدلهای زبانی بزرگ مثل GPT میرسه تا وارد عمل بشن. این مدلها میان و یه پاسخ نهایی تولید میکنن – که میتونه خلاصهشده، بازنویسیشده یا حتی نقلقول مستقیم از منابع باشه.

اینجا همون لایه استدلال (reasoning layer) وارد میشه. دیگه اصلاً مهم نیست منبع اطلاعات از کجا بوده – فقط این مهمه که آیا اون اطلاعات، به پاسخ دادن به سوال کاربر کمک میکنه یا نه.

ایندکس هنوز هست – اما با ظاهر جدید

الان دیگه خبری از خزیدن و منتظر موندن برای رتبه گرفتن توی نتایج گوگل نیست. توی ساختار جدید، محتوا به صورت بردار ذخیره میشه توی پایگاهداده برداری (Vector DB) و قابل بازیابی بر اساس معناست، نه فقط متا دیتا یا لینکسازی.

برای دادههای داخلی، این فرایند تقریباً لحظهای انجام میشه.

برای محتوای عمومی وب، هنوز خزندههایی مثل GPTBot یا Google-Extended از صفحات بازدید میکنن، اما هدفشون ساختن SERP نیست – دارن مفهوم محتوا رو برای استفاده در پاسخهای هوش مصنوعی پردازش میکنن.

چرا این ساختار جدید برنده است (البته برای کارهای درست)

این مدل جدید جایگزین کامل جستجوی سنتی نمیشه. ولی ازش جلو میزنه – مخصوصاً در کارهایی که موتورهای جستجوی سنتی هیچوقت درشون خوب عمل نمیکردن.

مثالهایی از جاهایی که این مدل فوقالعادهست:

-

دنبال چیزی توی اسناد داخلی شرکت میگردی؟ بیرقیب عمل میکنه.

-

خلاصه کردن متنهای حقوقی سنگین؟ بازی تمومه.

-

پیدا کردن قسمتهای مرتبط بین ۱۰ فایل PDF مختلف؟ هیچ مدل سنتی به گرد پاش نمیرسه.

قابلیتهای کلیدی این ساختار:

-

سرعت بالا: پایگاهدادههای برداری تو میلیثانیه نتایج رو میدن. نه خزیدن لازم داره، نه تأخیر.

-

دقت بالا: به جای فقط تکرار کلمات، به شباهت معنایی توجه میکنه.

-

کنترل کامل: میتونی خودت تعیین کنی چه محتوایی وارد سیستم بشه – نه صفحات تصادفی، نه اسپم سئو.

-

امنیت برند: نه تبلیغی در کاره، نه رقبا میان تو نتایجت ظاهر شن.

برای همین هم هست که بخشهایی مثل جستجوی سازمانی، پشتیبانی مشتری و سیستمهای مدیریت دانش داخلی دارن سریع وارد این حوزه میشن. و الان هم شاهدیم که جستجوی عمومی (مثل همون چیزی که ماها تو گوگل استفاده میکنیم) هم داره به این سمت حرکت میکنه.

چطور «نالج گراف» (Knowledge Graph) این ساختار رو قویتر میکنه؟

بردارها خیلی قدرتمندن – ولی کمی مبهم عمل میکنن. یعنی میان مفهوم کلی رو تشخیص میدن، اما ارتباط دقیق بین موجودیتها (entities) مثل آدم، برند یا محصول رو نمیفهمن.

اینجاست که نالج گراف یا همون نمودار دانش وارد بازی میشه.

نالج گراف مشخص میکنه چه ارتباطاتی بین موجودیتها وجود داره. مثلاً کمک میکنه بفهمیم منظور از “Apple” شرکت اپله یا میوه؟ یا کلمه “آن” به مشتری اشاره داره یا به محصول؟

وقتی این دو با هم ترکیب میشن:

-

پایگاهداده برداری، محتوای مرتبط رو پیدا میکنه

-

نالج گراف، رابطه بین مفاهیم رو شفاف میکنه

-

مدل زبانی بزرگ (LLM) همه اینا رو به زبان طبیعی برای کاربر توضیح میده

پس لازم نیست بین استفاده از نالج گراف یا استک جدید یکی رو انتخاب کنی. بهترین سیستمهای هوش مصنوعی از هر دو همزمان استفاده میکنن تا پاسخهایی دقیق، طبیعی و مفید بدن.

راهنمای تاکتیکی: بهینهسازی برای بازیابی اطلاعات توسط هوش مصنوعی

قبل از اینکه بریم سراغ روشهای بهینهسازی برای هوش مصنوعی، یه مرور سریع بکنیم روی چیزی که قبلاً برامون عادی شده بود: اینکه چطور توی سرچ سنتی رتبه بگیریم.

فقط اینو بگم که این یه لیست کامل نیست؛ صرفاً میخوایم یه مقایسه داشته باشیم. حتی همین سئو سنتی هم خودش پیچیدگیهای زیادی داره (با تجربهای که از تیم جستجوی Bing داشتم، خوب میدونم)، ولی وقتی ببینی با هوش مصنوعی چه اتفاقاتی میافته، این مدل سنتی خیلی ساده به نظر میاد!

برای اینکه توی نتایج سرچ سنتی رتبه بگیری، معمولاً باید این چیزها رو رعایت کنی:

-

صفحات قابل کراول داشته باشی

-

محتوای مرتبط با کلمه کلیدی تولید کنی

-

تگ عنوان (Title Tag) بهینه باشه

-

سایتت سریع لود بشه

-

از سایتهای معتبر بکلینک بگیری

-

ساختار داده (Structured Data) داشته باشی

-

لینکسازی داخلی درست انجام بدی

علاوه بر اینها، فاکتورهایی مثل E-E-A-T (تجربه، تخصص، اعتبار و اعتماد)، نمایش صحیح در موبایل و رفتار کاربر روی سایت هم مهمن. در کل، ترکیبی از بهداشت فنی، محتوای مرتبط و اعتبار بیرونی باعث رتبه گرفتن میشه.

اما حالا بریم سراغ بخش مهم ماجرا: چطور توی مدل جدیدی که با کمک مدلهای زبانی بزرگ مثل ChatGPT، Gemini، Copilot، Claude و Perplexity کار میکنن دیده بشیم؟

در ادامه چند تکنیک واقعی و قابل اجرا برای این کار آورده شده:

۱. محتوای خودت رو برای «بازیابی معنایی» تکهتکه کن

محتوای بلند رو به بخشهای قابل بازیابی تقسیم کن.

از تگهای معنایی HTML مثل <h2> و <section> استفاده کن تا موضوعات مختلف جدا بشن.

استفاده از فرمتهایی مثل سوال و جواب (FAQ) یا چیدمانهای ماژولار به LLM کمک میکنه راحتتر بتونه از محتوای تو استفاده کنه.

۲. وضوح رو به خلاقیت ترجیح بده

واضح و مستقیم بنویس. دنبال این نباش که تحسین بشی، دنبال این باش که فهمیده بشی.

از اصطلاحات سنگین، استعاره یا مقدمههای طولانی پرهیز کن.

جوابهای شفاف، دقیق و سادهای بنویس که با شکل پرسشهای کاربران هماهنگ باشه.

۳. سایتت رو برای رباتهای هوش مصنوعی قابل خزش کن

اگه GPTBot، Google-Extended یا CCBot نتونن به محتوای تو دسترسی داشته باشن، اصلاً انگار وجود نداری!

مطمئن شو محتوای مهم داخل HTML قابل دیدنه، نه فقط با جاوااسکریپت.

از تگهای Schema.org مثل FAQPage یا Article استفاده کن تا نوع محتوا رو به رباتها بشناسونی.

۴. اعتماد و اعتبار رو نشون بده

مدلهای زبانی به منابع قابل اعتماد گرایش دارن.

پس از نویسنده، تاریخ انتشار، صفحه تماس، منابع خارجی و بیوی نویسنده استفاده کن.

این نشونهها شانس دیده شدن محتوا توسط AI رو بالا میبرن.

۵. مثل یه گراف دانش داخلی رفتار کن

بین صفحات مرتبط لینکسازی کن و ارتباط مفهومی بین اونها بساز.

از مدلهای ستونی-شاخهای (Hub & Spoke)، دیکشنریهای داخلی و لینکهای متنی استفاده کن.

این کار ساختار معنایی سایتت رو قوی میکنه و کمک میکنه بهتر در حافظه برداری (vector embedding) ذخیره بشی.

۶. موضوعات رو کامل و قابل تقسیم پوشش بده

فقط به سوال اصلی جواب نده، زوایای مختلفش رو هم پوشش بده.

از ساختارهایی مثل «چی هست؟»، «چرا؟»، «چطور؟»، «مقایسه با چی؟»، «چه زمانی؟» استفاده کن.

خلاصهها، چکلیستها و جدولها هم کمک زیادی میکنن.

۷. با اطمینان بنویس

LLMها روی محتوایی که با اعتماد به نفس نوشته شده تمرکز بیشتری دارن.

از جملات قطعی و روشن استفاده کن.

تا جایی که ممکنه از عباراتی مثل “شاید”، “احتمالاً” یا “برخی معتقدند” پرهیز کن.

۸. یک مفهوم رو با چند بیان مختلف بگو

یه نکته مهم رو با جملهبندیهای مختلف تکرار کن.

این کار باعث میشه مدلهای زبانی راحتتر تو رو پیدا کنن چون بازیابی اطلاعات بر اساس معناست، اما تنوع در بیان پوشش وسیعتری ایجاد میکنه.

۹. پاراگرافهای کوتاه و متمرکز بنویس

هر پاراگراف باید فقط یه ایده رو منتقل کنه، نه بیشتر.

از ساختارهای ساده و واضح استفاده کن تا محتوای تو راحتتر در پایگاه دادههای برداری ذخیره و بازیابی بشه.

۱۰. اسامی و مفاهیم رو کامل بگو

وقتی میگی “مدل جدید”، منظورتو دقیق بگو: مثلاً “مدل GPT-4 ساخت OpenAI”.

شفافسازی اسمها و مفاهیم به مدلهای زبانی کمک میکنه محتوای تو رو بهتر درک کنن و با گراف دانش ترکیب کنن.

۱۱. مثالها و آمار رو نزدیک به ایده اصلی بیار

وقتی یه ادعا میکنی، سعی کن بلافاصله پشتش مثال یا عدد بیاری.

نه اینکه چند پاراگراف بعد تازه توضیحش رو بدی.

این کار انسجام بخشهای بازیابیشده رو بیشتر میکنه و احتمال استفاده از محتوا توسط LLM رو بالا میبره.

۱۲. بخشهایی با ساختار قابل استخراج بساز

برای خزندههای AI مثل Perplexity یا You.com، اطلاعات واضح و فشرده بساز.

مثلاً از بولتپوینتها، خلاصه جوابها یا بخش “نکته کلیدی” استفاده کن.

این کار باعث میشه بخشهایی از محتوای تو مستقیماً در پاسخهای تولیدی اونها استفاده بشه.

۱۳. با محتواهای پشتیبان، فضای برداری رو تغذیه کن

یه شبکه متراکم از محتواهای مرتبط بساز.

مثلاً دیکشنریها، صفحههای مقایسه، مطالعه موردی (Case Study) و تعریف اصطلاحات منتشر کن و بهم لینک بده.

این کار باعث میشه محتواهای اصلی تو بیشتر و بهتر در سیستمهای بازیابی معنایی دیده بشن.

نکته پایانی: ببین محتوایت داره استفاده میشه یا نه

خیلی راحت، برو سراغ ChatGPT (با قابلیت مرور فعال) یا Perplexity و ازشون سوالهایی بپرس که انتظار داری محتوای سایتت پاسخشون باشه.

اگه توی جوابشون اثری از سایت تو نیست، وقتشه بازنگری کنی.

ساختار رو بهینه کن، واضحتر بنویس، محتوای پشتیبان بساز و دوباره تست کن.

یه نکته پایانی مهم: محتوای تو حالا یه زیرساخت حساب میشه

دیگه نباید سایتت رو فقط به چشم یه مقصد نگاه کنی. تو دنیای جستجوی هوش مصنوعی، سایت تو ماده خام حساب میشه؛ یعنی اون چیزی که سیستمهای هوشمند مثل ChatGPT، Gemini یا Perplexity میان ازش تغذیه میکنن تا جواب تولید کنن.

تو این شرایط، بهترین اتفاقی که میتونه برای محتوای تو بیفته اینه که:

-

ازش نقلقول بشه

-

بهش ارجاع داده بشه

-

یا توی پاسخ نهایی که به کاربر ارائه میشه، ترکیب و استفاده بشه

با زیاد شدن ابزارهای جستجوی جدید – مثل نسل جدید عینکهای Ray-Ban با هوش مصنوعی – این قضیه جدیتر از قبل میشه. این وسایل فقط ابزار پوشیدنی نیستن، درواقع نقطه ورود به جستجو هستن.

صفحات سایت هنوز اهمیت دارن، اما دارن تبدیل میشن به یه جور داربست اطلاعاتی.

اگه میخوای تو این بازی برنده باشی، دیگه نباید فقط دنبال رتبه گرفتن تو گوگل

ترجمه : Inside the AI-powered retrieval stack – and how to win in it

من، جعفر جلالی، سایت ایران بک لینک را راهاندازی کردم. با تکیه بر تجربیاتی که طی سالها در کسبوکارهای آنلاین به دست آوردهام و همچنین استفاده از منابع اصلی و معتبر انگلیسی، تلاش کردم بهترین مقالات و منابع آموزشی در زمینه سئو را به زبان فارسی گردآوری کنم. هدف من از ایجاد ایران بک لینک این است که به کسبوکارهای آنلاین کمک کنم تا با دسترسی به اطلاعات کاربردی و جامع، به موفقیت بیشتری دست پیدا کنند. امیدوارم که ایران بک لینک بتواند به منبعی قابلاعتماد برای شما تبدیل شود.