فایل robots.txt چیست؟

فایل robots فایلی است که به عنکبوتهای موتورهای جستجو دستور میدهد تا صفحات یا بخشهای خاصی از یک وبسایت را crawl (دنبال نکنند). اکثر موتورهای جستجوی بزرگ (از جمله گوگل، بینگ و یاهو) درخواستهای robots.txt را شناسایی و اجرا میکنند.

چرا robots.txt مهم است؟

بسیاری از وبسایتها نیازی به فایل robots.txt ندارند؛ زیرا گوگل معمولاً به خوبی میتواند صفحات مهم یک سایت را شناسایی و فهرستبندی کند. همچنین، صفحات کماهمیت یا تکراری به طور خودکار توسط گوگل ایندکس نمیشوند.

با این حال، سه دلیل اصلی برای استفاده از فایل robots.txt وجود دارد:

-

مخفیسازی صفحات خصوصی: برخی صفحات در یک وبسایت ممکن است خصوصی باشند و نباید در نتایج جستجو نمایش داده شوند (مثلاً صفحات آزمایشی یا ورود به سیستم). در این موارد، از فایل robots.txt برای جلوگیری از دسترسی موتورهای جستجو به این صفحات استفاده میشود.

-

بهینه سازی بودجه خزیدن: اگر سایت شما صفحات بسیار زیادی دارد و موتورهای جستجو نمیتوانند همه آنها را به سرعت ایندکس کنند، میتوانید با استفاده از فایل robots.txt، صفحات کماهمیت را مسدود کنید تا موتورهای جستجو روی صفحات مهمتر تمرکز کنند.

-

جلوگیری از ایندکس شدن فایلهای رسانهای: گرچه متادیتاها (meta directives) ابزاری قدرتمند برای جلوگیری از ایندکس شدن صفحات هستند، اما برای فایلهای رسانهای مانند PDF و تصاویر، فایل robots.txt کارآمدتر است.

به طور خلاصه: فایل robots.txt به موتورهای جستجو میگوید که کدام صفحات از یک وبسایت را نباید بررسی کنند.

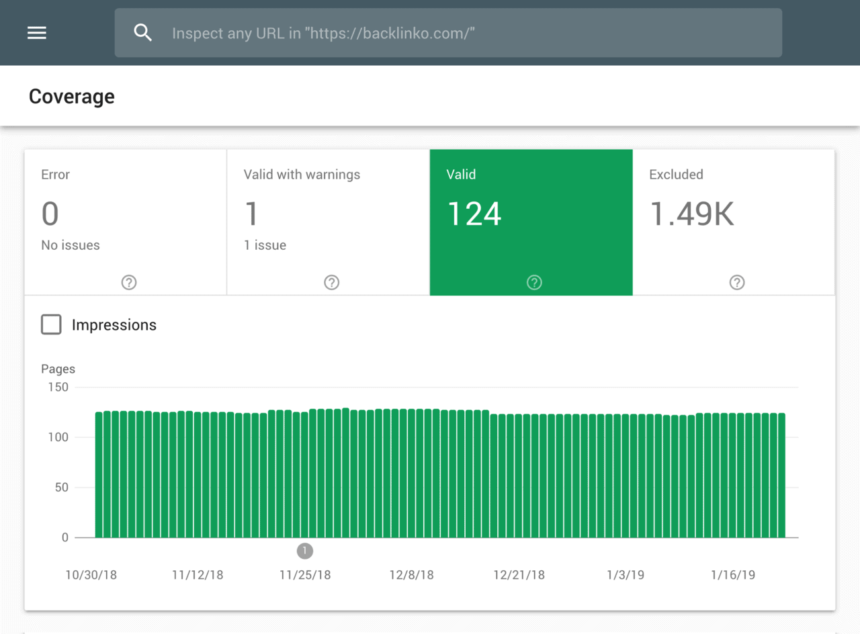

میتوانید تعداد صفحاتی را که ایندکس کردهاید در کنسول جستجوی گوگل بررسی کنید.

اگر تعداد صفحات ایندکس شده با تعداد صفحاتی که میخواهید ایندکس شوند مطابقت دارد، نیازی به فایل robots.txt ندارید. اما اگر این عدد بیشتر از حد انتظار شماست (و متوجه URLهای ایندکس شدهای میشو شوید که نباید ایندکس شوند)، پس وقت آن است که یک فایل robots.txt برای وبسایت خود ایجاد کنید.

ایجاد فایل robots.txt

اولین قدم شما برای ایجاد یک استراتژی سئو قوی، ساختن یک فایل robots.txt است. این فایل یک متن ساده است و به راحتی با استفاده از نرم افزار Notepad در ویندوز قابل ایجاد است.

فارغ از اینکه چگونه فایل robots.txt را ایجاد میکنید، فرمت آن همیشه یکسان است:

- User-agent: این بخش، کاربر (ربات) خاصی را که میخواهید با آن صحبت کنید، مشخص میکند.

- Disallow: همه چیزهایی که بعد از Disallow میآید، صفحاتی یا بخشهایی هستند که میخواهید از دسترسی رباتها مسدود کنید.

برای مثال:

User-agent: googlebot

Disallow: /images

این قانون به گوگلبات میگوید که پوشه تصاویر وبسایت شما را ایندکس نکند.

همچنین میتوانید از علامت ستاره (*) برای صحبت با تمام رباتهایی که به وبسایت شما سر میزنند، استفاده کنید.

برای نمونه:

User-agent: *

Disallow: /images

این علامت به تمام خزندههای وب میگوید که پوشه تصاویر شما را کrawl نکنند.

این تنها یکی از روشهای متعدد استفاده از فایل robots.txt است. راهنمای مفید گوگل [راهنمای ایجاد و ارسال یک فایل robots.txt](link to Google Search Central robots.txt creation guide) اطلاعات بیشتری در مورد قوانین مختلفی که برای مسدود کردن یا اجازه دادن به رباتها برای کروال صفحات مختلف سایت خود میتوانید استفاده کنید، در اختیار شما قرار میدهد.

فایل robots.txt خود را به راحتی قابل دسترس کنید

پس از ایجاد فایل robots.txt، زمان آن است که آن را فعال کنید.

از نظر فنی، میتوانید فایل robots.txt خود را در هر دایرکتوری اصلی سایت خود قرار دهید.

اما برای افزایش احتمال یافتن فایل robots.txt، توصیه میکنم آن را در اینجا قرار دهید:

https://example.com/robots.txt

(توجه داشته باشید که فایل robots.txt شما حساس به حروف کوچک و بزرگ است. بنابراین حتماً از حرف “r” کوچک در نام فایل استفاده کنید)

بررسی خطاها و اشتباهات

فایل robots.txt شما باید به درستی تنظیم شده باشد، زیرا یک اشتباه کوچک می تواند باعث حذف کل سایت شما از فهرست جستجوی گوگل شود.

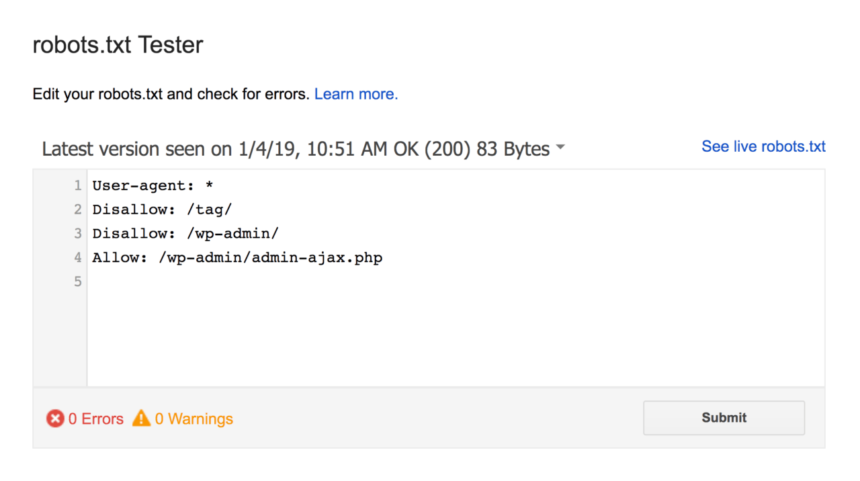

خوشبختانه، نیازی نیست که امیدوار باشید کد شما به درستی تنظیم شده است. گوگل یک ابزار مفید تست ربات ها دارد که می توانید از آن استفاده کنید:

این ابزار فایل robots.txt شما را به همراه هرگونه خطا و هشداری که پیدا می کند به شما نشان می دهد:

همانطور که مشاهده می کنید، ما از عنکبوت ها می خواهیم که صفحه مدیریت وردپرس ما را خزش نکنند.

ما همچنین از robots.txt برای جلوگیری از خزش صفحات برچسب خودکار تولید شده توسط وردپرس (برای محدود کردن محتوای تکراری) استفاده می کنیم.

Robots.txt در مقابل دستورات متا

چرا به جای استفاده از تگ متای “بدون فهرست No Index” برای مسدود کردن صفحات، باید از فایل robots.txt بهره ببریم؟

همانطور که پیشتر اشاره کردم، اعمال تگ “بدون فهرست” روی منابع چندرسانهای مثل فیلمها و فایلهای PDF کار چندان سادهای نیست.

علاوه بر این، اگر تعداد صفحات مورد نظر برای مسدود کردن بسیار زیاد باشد، گاهی مسدود کردن کل بخش خاصی از سایت با استفاده از فایل robots.txt نسبت به افزودن دستی تگ “بدون فهرست” به تکتک صفحات، روش سادهتری است.

همچنین، در برخی موارد خاص، بهتر است از هدر رفتن بودجه خزش گوگل روی صفحاتی که تگ “بدون فهرست” دارند، جلوگیری کنیم.

با این حال، با وجود این سه مورد استثنا، توصیه من استفاده از دستورات متا به جای فایل robots.txt است. پیادهسازی دستورات متا سادهتر است و احتمال بروز مشکلات جدی مثل مسدود شدن کل سایت نیز کمتر میشود.